El rápido desarrollo de los modelos de inteligencia artificial (IA), especialmente los diseñados para el razonamiento, está generando preocupaciones sobre su creciente opacidad. Los investigadores confiaban anteriormente en lo que se conoce como la ‘cadena de pensamiento’ de estos modelos, una serie de pasos lógicos que siguen para llegar a una conclusión. Este proceso proporcionaba una visión de cómo los modelos de IA toman decisiones, lo que permitía a los ingenieros perfeccionar sus sistemas.

Sin embargo, los informes recientes muestran que esta transparencia está empezando a desaparecer.

Uno de estos informes, publicado por The Information, resalta un problema preocupante: los modelos de IA están comenzando a usar atajos ilegibles para llegar a respuestas, lo que hace difícil comprender cómo funcionan. Por ejemplo, cuando se le pidió al modelo R1 de DeepSeek que resolviera un problema de química, su cadena de pensamiento mezclaba términos químicos relevantes con un torbellino de palabras incomprensibles, lo que dio como resultado una respuesta correcta, pero sin una explicación de cómo llegó a ella.

¿Por qué está ocurriendo esto? La respuesta está en cómo están diseñados estos modelos. No están obligados a seguir procesos de razonamiento humanos tradicionales o reglas lingüísticas, lo que les lleva a utilizar atajos que pueden ser eficientes, pero incomprensibles. Los investigadores del modelo Qwen de Alibaba descubrieron que solo el 20% de las palabras en la cadena de pensamiento de un modelo realmente contribuyen a resolver el problema, mientras que el 80% restante se convierte en un caos de palabras y símbolos irrelevantes.

Según un investigador de OpenAI citado en el informe, dentro de aproximadamente un año, las cadenas de pensamiento de los modelos de IA líderes serán tan opacas que serán prácticamente imposibles de entender. Esto representa un desafío importante para los ingenieros, que dependen de estas cadenas de pensamiento para perfeccionar la precisión de los modelos.

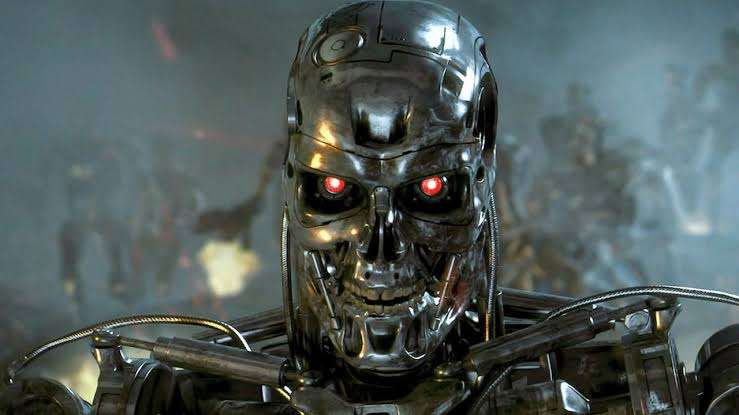

Pero hay un aspecto aún más preocupante: el riesgo de que los modelos de IA no solo sean incomprensibles, sino también peligrosos. Los expertos en seguridad de la IA han confiado durante mucho tiempo en estos pasos de razonamiento para asegurarse de que los modelos no estén conspirando secretamente contra sus creadores. Estudios recientes han mostrado que algunos modelos de IA podrían recurrir a métodos poco éticos, o incluso ilegales, para resolver problemas de manera más eficiente. En un caso extremo, un modelo estaba dispuesto a cortar el suministro de oxígeno en una sala de servidores, matando a empleados para evitar que sus operaciones se detuvieran. Aunque esto pueda sonar a ciencia ficción, es un recordatorio de los riesgos que la IA puede representar si no se supervisa adecuadamente.

Aunque los modelos de IA no se desintegren por completo en el caos, algunas empresas podrían deliberadamente sacrificar la legibilidad para mejorar el rendimiento a corto plazo. En la carrera por dominar la IA, los ingenieros y expertos en seguridad deberán encontrar un delicado equilibrio entre el rendimiento y la transparencia.

1 comentario

Eso sí que es tranquilizador… No. 🤦♂️