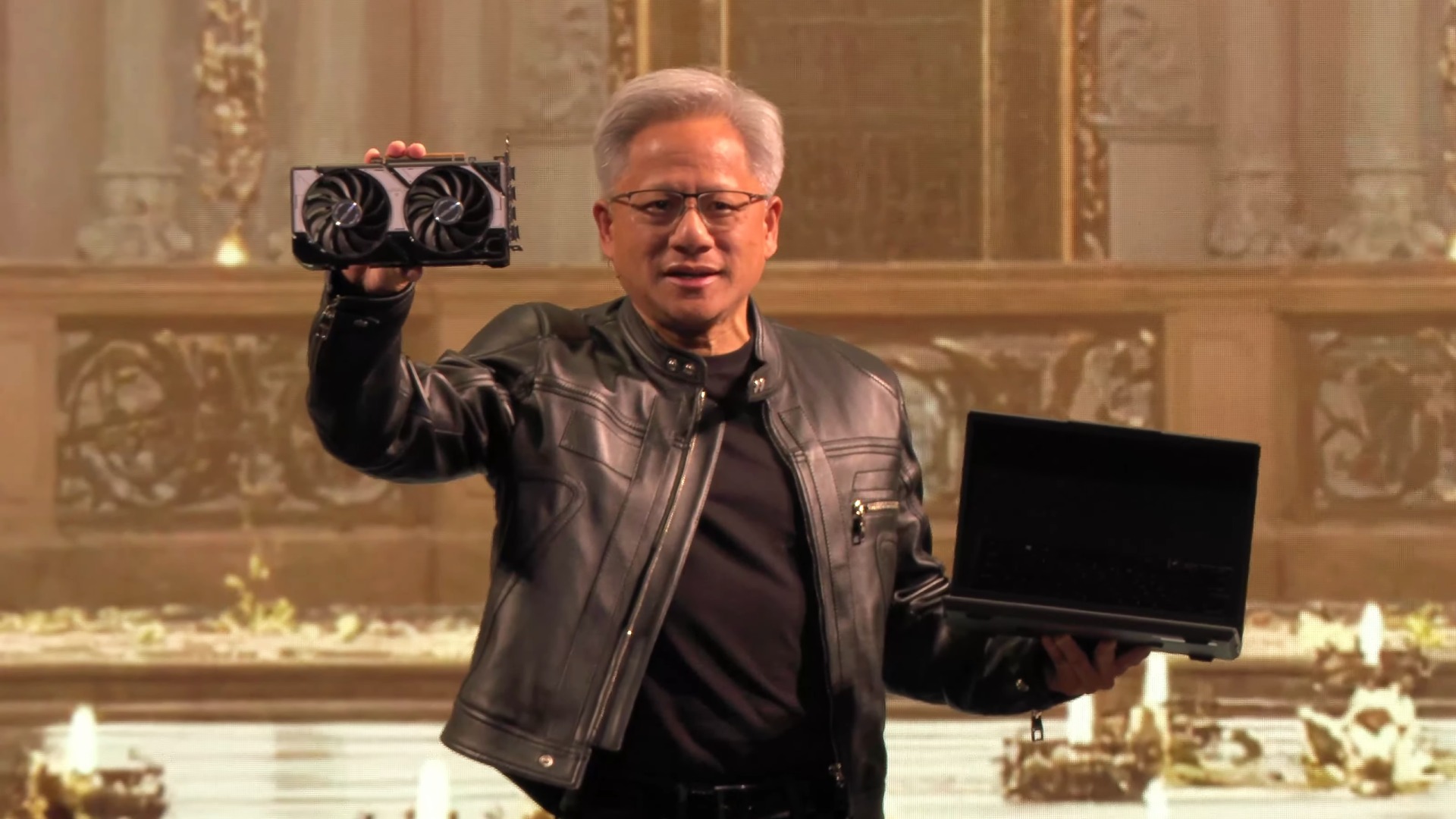

Durante años, NVIDIA fue vista como la reina indiscutida del hardware para inteligencia artificial. Sus GPUs (unidades de procesamiento gráfico) se convirtieron en la base de los avances en IA, tanto en laboratorios de investigación como en servicios en la nube.

Pero el panorama ya no es tan claro: Google y Amazon están decididos a desafiar ese dominio con chips propios que prometen menores costos y una estrategia a largo plazo para ganar terreno.

Google impulsa con fuerza sus Tensor Processing Units (TPUs). Estos procesadores, diseñados en un inicio para optimizar las tareas internas de machine learning, evolucionaron hasta convertirse en una opción atractiva frente a las costosas GPUs de NVIDIA. Según The Information, la compañía ya se encuentra en conversaciones con proveedores más pequeños de infraestructura en la nube para que instalen TPUs junto con GPUs de NVIDIA en sus centros de datos. De esa forma, Google busca crear una red de adopción que aumente la visibilidad y la relevancia de sus chips.

De hecho, informes anteriores ya habían señalado que OpenAI, la empresa detrás de ChatGPT, probó el uso de TPUs para parte de sus cargas de trabajo. Aunque se trató de un cambio limitado, la motivación fue clara: los altos precios de las soluciones de NVIDIA. Ahora, el nuevo reporte cita siete fuentes diferentes y refuerza la idea de que Google no solo prueba, sino que está seriamente apostando por expandir su tecnología más allá de sus propias instalaciones.

El movimiento también responde a un problema interno: Google cuenta con suficientes chips, pero no logra ampliar su infraestructura de centros de datos al mismo ritmo que crece la demanda de cómputo en IA. Confiar en proveedores externos con TPUs permite a la compañía equilibrar esa limitación, manteniendo el servicio a sus clientes y sosteniendo sus ambiciosos proyectos de inteligencia artificial.

Amazon, por su parte, desarrolla su chip Trainium con un objetivo similar: reducir la dependencia de NVIDIA. Sin embargo, el camino no ha sido fácil. Los resultados más recientes de AWS mostraron un enfriamiento en el crecimiento del negocio en la nube, lo que se atribuye en parte a la apuesta por Trainium. El mercado reaccionó con fuerza: las acciones de Amazon cayeron casi un 10%. Analistas remarcaron que la adopción es complicada, y un dato clave lo confirma: Anthropic, una de las startups más importantes en IA y usuaria principal de Trainium, sigue prefiriendo trabajar con GPUs de NVIDIA.

La batalla se centra en la eterna disyuntiva: costo contra rendimiento. NVIDIA ofrece el máximo desempeño, confianza y un ecosistema consolidado. Renunciar a esa seguridad implica un riesgo que muchas empresas no están dispuestas a correr. No obstante, si TPUs o Trainium logran acercarse en potencia y confiabilidad, la ventaja de costos podría cambiar radicalmente el equilibrio del mercado.

Por ahora, NVIDIA mantiene el liderazgo, pero ya aparecen señales de presión. La jugada de Google recuerda a lo que hizo con Android: ganar escala y accesibilidad para erosionar poco a poco la posición del rival dominante. Amazon, pese a los tropiezos, difícilmente abandone su estrategia y seguirá invirtiendo en Trainium. El desenlace de esta carrera no solo definirá el futuro del mercado de chips de IA, sino también la dirección que tomará la computación global en la próxima década.

2 comentarios

Nvidia aún manda, Google recién calentando motores 😅

creo que NVIDIA todavía tiene varios años tranquilos