Hace no tanto tiempo, hablar de HBM significaba, básicamente, hablar de SK hynix y Micron. Samsung aparecía en segundo plano, marcada por intentos fallidos de cualificación con NVIDIA y por un catálogo que no terminaba de convencer a los grandes jugadores de la nube. Esa etapa está cerca de cambiar.

Según fuentes de la industria, la compañía coreana está a un paso de conseguir la aprobación completa de sus pilas HBM4 por parte de NVIDIA, posiblemente incluso este mismo mes, lo que la devolvería al centro de la cadena de valor más jugosa de la inteligencia artificial: la memoria de alto ancho de banda.

Para entender la importancia de este giro, hay que recordar por qué Samsung se quedó atrás. En plena explosión de demanda de HBM3 y HBM3E, cuando cada nuevo acelerador de IA se vendía antes de salir de la fábrica, los primeros módulos HBM de la marca se toparon con problemas serios: fiabilidad de la DRAM, gestión térmica complicada al apilar muchas capas y moverlas a frecuencias extremas, y un comportamiento que no alcanzaba los estándares de NVIDIA y los hiperescaladores. El resultado fue simple y doloroso: los grandes contratos de memoria para GPU de IA se fueron a la competencia.

La respuesta de Samsung no fue un parche rápido, sino una reconstrucción a fondo. La generación de DRAM 1c destinada a HBM4 se rediseñó prácticamente desde cero y se combinó con un die base en proceso de 4 nm. El objetivo era ambicioso: mantener los niveles de rendimiento que exige la IA de última generación, contener el consumo y la temperatura, y al mismo tiempo lograr rendimientos de fabricación que permitan producir en volumen, no solo enseñar prototipos bonitos en diapositivas. A nivel interno, la empresa ya ha marcado el proyecto como listo para producción y está enviando muestras de HBM4 a clientes clave para pruebas de calidad y fiabilidad.

Esas muestras ya circulan por los laboratorios de NVIDIA y otros socios, donde se someten a pruebas de estrés, ciclos térmicos y validaciones de compatibilidad con controladores y empaquetados avanzados. Los analistas calculan que la fase final de verificación externa podría cerrarse en cuestión de semanas. Pero lo que de verdad decidirá el éxito comercial no es solo el visto bueno de NVIDIA, sino las tasas de yield que consiga Samsung cuando entre en producción masiva. Un fallo en una sola capa puede arruinar todo un stack de HBM, así que cada punto porcentual de rendimiento cuenta.

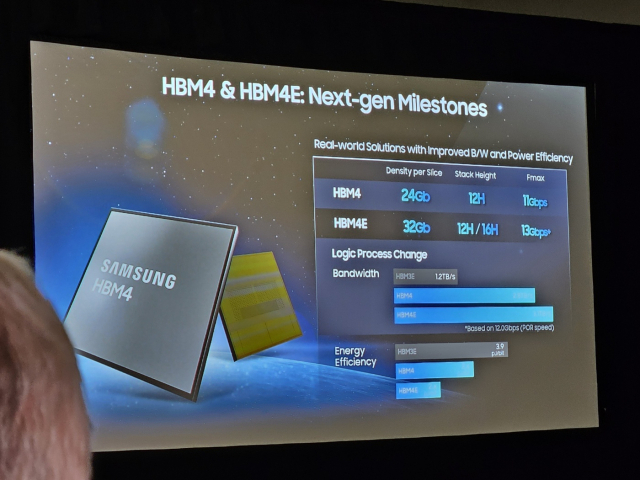

Sobre el papel, HBM4 llega con credenciales más que serias. Samsung apunta a velocidades de unos 11 Gbps por pin, lo que se traduce, según la configuración, en alrededor de 2,8 TB por segundo de ancho de banda por pila. Y el roadmap ya mira más allá, hacia HBM4E, con objetivos por encima de 13 Gbps por pin y cifras que superan los 3,2 TB por segundo por stack. Para hacer aún más atractiva su propuesta, la compañía juega también con el precio: ofrecer rendimiento puntero con condiciones económicas agresivas es la forma más directa de convencer a clientes que hoy dependen en exceso de uno o dos proveedores.

En paralelo, las fábricas se están reorganizando. Una parte nada despreciable de la capacidad que se había preparado para DDR5 y GDDR6 se está redirigiendo a la producción de HBM4. No es casualidad: en un mercado en el que cada centro de datos quiere entrenar modelos más grandes y más rápidos, cualquier fabricante capaz de entregar HBM en cantidades significativas vende prácticamente todo lo que produce. Para el negocio de DRAM de Samsung, que venía de varios trimestres de precios flojos y márgenes ajustados, este cambio de mix productivo convierte a HBM4 en algo más que un escaparate tecnológico; puede convertirse en uno de los motores de beneficio de la compañía.

Desde el punto de vista de NVIDIA, recuperar a Samsung como socio fuerte también tiene lógica. Depender demasiado de un único proveedor de HBM es un riesgo cuando las hojas de ruta completas de GPU y aceleradores de IA se apoyan en esa memoria. Las próximas generaciones de plataformas, a menudo asociadas a nombres en clave como Vera Rubin, necesitarán enormes reservas de ancho de banda y capacidad. Incorporar a Samsung a la lista de proveedores de HBM4 no solo diversifica el riesgo, sino que también refuerza la posición de NVIDIA a la hora de negociar precios, volúmenes y prioridades de suministro.

HBM4, además, no es un proyecto exclusivo para NVIDIA. AMD tiene sus propios aceleradores de IA y necesita alternativas competitivas de memoria. Y al mismo tiempo, gigantes como Google, Meta y Amazon llevan años desarrollando ASIC y chips personalizados para cargas de trabajo de aprendizaje automático, donde la memoria HBM ya es un requisito básico. Si Samsung demuestra que puede entregar pilas HBM4 con buen yield y en volúmenes sostenidos, sus chips terminarán alimentando una gran variedad de soluciones de IA, desde GPUs hasta aceleradores dedicados y procesadores a medida para la nube.

Para la comunidad de jugadores de PC, todo esto suena interesante pero lejano. La realidad es que HBM4 seguirá siendo, en el corto y medio plazo, territorio de centros de datos y estaciones de trabajo de gama muy alta, mientras las tarjetas gráficas de consumo continúan evolucionando con GDDR. El siguiente salto ahí es GDDR7. Samsung llegó a hablar de módulos de hasta 48 Gbps a finales de 2024, pero el calendario real se ha ido desplazando y ahora es SK hynix quien se perfila para mostrar GDDR7 a 48 Gbps en citas como ISSCC 2026. Es perfectamente posible que las primeras GPU de juegos con esas velocidades no lleguen al mercado hasta 2027.

Aun así, incluso con configuraciones más realistas, la comparación deja claro por qué HBM juega en otra liga. Con GDDR7 a 36 Gbps por pin, una interfaz de 256 bits ronda 1,1 TB por segundo de ancho de banda. Con 384 bits, se puede alcanzar alrededor de 1,7 TB por segundo, y con un bus extremo de 512 bits se arañan unos 2,3 TB por segundo. Son cifras impresionantes para gaming, pero siguen por debajo de lo que puede ofrecer un solo stack de HBM4 con 2,8 TB por segundo, y todavía más lejos de un futuro HBM4E por encima de los 3 TB por segundo.

Por eso, la vuelta de Samsung al tablero de HBM es relevante mucho más allá del orgullo corporativo. Un tercer actor fuerte en la cumbre de la memoria de alto ancho de banda hace que toda la cadena de suministro de IA sea más resistente, presiona a SK hynix y Micron para acelerar sus propias hojas de ruta y reduce el riesgo de que un cuello de botella de memoria frene la próxima ola de innovaciones en modelos de lenguaje y sistemas de recomendación. Aunque es probable que el jugador medio no vea HBM4 en su tarjeta gráfica doméstica en bastante tiempo, la competencia entre estos tres grandes puede traducirse, a medio plazo, en memorias más eficientes, productos mejor equilibrados y una dinámica de precios menos asfixiante en la gama alta.

Si la cualificación con NVIDIA se confirma y la producción masiva mantiene los niveles de yield prometidos, Samsung habrá pasado, en pocos años, de ser la eterna aspirante en HBM a convertirse en una de las columnas que sostienen la infraestructura de memoria de la nueva era de la computación basada en IA.