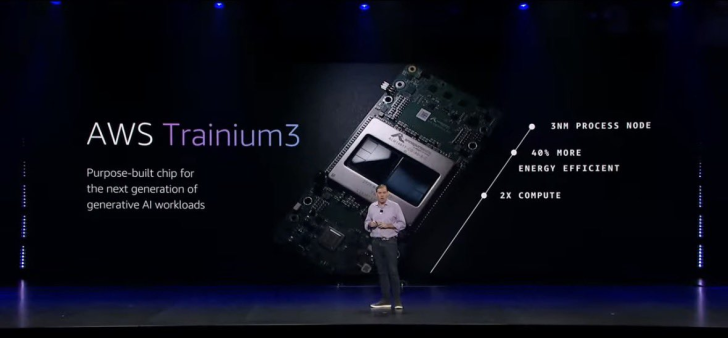

Amazon hace tiempo dejó de conformarse con alquilar GPU en la nube, pero con la familia Trainium da un paso más y se coloca de lleno en la liga de los diseñadores de chips para inteligencia artificial. En el escenario de AWS re:Invent 2025 la compañía dejó este mensaje cristalino: los aceleradores propios son pieza central de su estrategia.

La prueba son los nuevos servidores Trainium3 UltraServers y el adelanto de la próxima generación de silicio, los chips Trainium4.

El movimiento llega en plena carrera de los gigantes tecnológicos por el silicio a medida. Google presume de sus TPUs, Meta desarrolla sus propios aceleradores, Microsoft impulsa la línea Maia, y Amazon responde ampliando con rapidez su catálogo Trainium. El objetivo no es pequeño: dar soporte a grandes modelos de lenguaje, sistemas generativos y cargas de trabajo de IA que han llevado al límite a las arquitecturas basadas exclusivamente en GPU, tanto en coste como en disponibilidad y consumo energético.

La estrella del anuncio son los Trainium3 UltraServers. Más que un servidor tradicional, se trata de un sistema fuertemente integrado que puede agrupar hasta 144 chips Trainium3 en un solo clúster. Según datos de AWS, esta configuración ofrece hasta 4,4 veces más potencia de cómputo que la generación previa de Trainium2 UltraServers, junto con alrededor de 4 veces más eficiencia energética y casi 4 veces más ancho de banda de memoria. Traducido al día a día de un equipo de IA, esto se convierte en modelos más grandes, conjuntos de datos más ambiciosos y entrenamientos mucho menos interminables.

En la práctica, un entrenamiento que antes podía bloquear recursos durante meses puede comprimirse en unas pocas semanas. El ciclo de iteración para probar nuevas arquitecturas, ajustar hiperparámetros o lanzar versiones especializadas de un modelo se acorta de forma drástica. Una vez que el modelo está listo, los mismos UltraServers se reutilizan para la fase de inferencia, atendiendo un volumen mucho mayor de peticiones simultáneas: chats, resúmenes, imágenes, código, lo que sea. El resultado es una reducción clara del coste por respuesta generada y un tiempo de salida al mercado más competitivo.

El truco para escalar así se llama NeuronSwitch-v1, la nueva tecnología de interconexión diseñada por Amazon. Cumple un papel parecido al de NVLink en el ecosistema de NVIDIA, pero está afinada específicamente para unir ASICs Trainium. AWS habla de la posibilidad de formar clústeres de hasta un millón de chips, una cifra que hace unos años sonaba a ciencia ficción. A esa escala, entrenar con conjuntos de datos de billones de tokens, o desplegar modelos que antes ni siquiera cabían en un solo centro de datos, pasa de teoría a realidad.

Esta capacidad no es solo un número bonito en una diapositiva. Los modelos generativos modernos son extremadamente sensibles a los cuellos de botella en memoria y red. Cuando la interconexión y el ancho de banda de memoria acompañan, los aceleradores pasan menos tiempo esperando datos y más tiempo calculando. Eso se traduce en mejores tasas de utilización del hardware, entrenamientos más estables y, a menudo, mayor calidad en las predicciones sin necesidad de disparar el presupuesto.

La eficiencia energética es otro punto clave. Si una nueva plataforma ofrece hasta cuatro veces más rendimiento por vatio, las empresas pueden aumentar su huella de IA sin multiplicar por cuatro sus facturas de electricidad o refrigeración. En un contexto en el que muchos centros de datos rozan los límites de potencia contratada, sacar más trabajo de la misma infraestructura eléctrica es casi tan importante como aumentar los teraflops brutos. Para muchos equipos, eso significa poder mantener más modelos en producción y probar más ideas sin tener que construir un nuevo CPD.

Los Trainium3 UltraServers encajan además en una tendencia más amplia: los fabricantes de ASIC están ampliando sus catálogos para aliviar la presión sobre las GPU, que siguen siendo caras y difíciles de conseguir a gran escala. Como proveedor de nube, Amazon tiene una posición privilegiada: controla el chip, la red de alta velocidad y la capa de software, desde el Neuron SDK hasta servicios como SageMaker. Eso le permite ofrecer pilas de infraestructura ajustadas al milímetro para cargas de IA concretas, en lugar de limitarse a vender instancias con GPU genéricas.

Por supuesto, Trainium3 no es el final del camino. Amazon también adelantó las primeras especificaciones de Trainium4, la próxima generación de aceleradores de IA. La promesa es contundente: hasta 6 veces más rendimiento en FP4, el formato de baja precisión que se ha convertido en estándar para entrenar y servir modelos gigantes, además de un aumento importante tanto en capacidad como en ancho de banda de memoria. En otras palabras, más músculo para LLM enormes, arquitecturas mixture-of-experts y flujos complejos que mezclan texto, imagen, audio y vídeo.

El detalle que más miradas ha captado, sin embargo, es la compatibilidad con NVLink de NVIDIA en Trainium4. Esto abre la puerta a clústeres híbridos donde GPU de NVIDIA y aceleradores Trainium conviven en el mismo entorno y comparten datos a gran velocidad. Para las organizaciones que llevan años invirtiendo en hardware NVIDIA y herramientas basadas en CUDA, esta compatibilidad reduce el riesgo: pueden sumar Trainium a su flota paso a paso, sin desmantelar todo lo que ya tienen funcionando.

Amazon asegura que el interés por sus chips de IA ya es notable. Uno de los casos más mencionados es Anthropic, que afirma haber reducido de forma significativa el coste de entrenamiento al migrar parte de sus cargas a Trainium. Para proveedores de modelos, startups y grandes empresas atrapadas entre la escasez de GPU y la volatilidad de precios, estos testimonios suenan a válvula de escape: seguir dentro del ecosistema de AWS, pero con una ecuación de coste y rendimiento más predecible.

Visto en perspectiva, el mensaje es claro: los grandes de la nube no quieren limitarse a comprar chips, quieren definirlos. Con Trainium3 UltraServers en el catálogo y Trainium4 en el horizonte, Amazon deja claro que está all-in en la carrera por los ASIC de IA. No solo quiere alquilar capacidad de cómputo, quiere influir directamente en cómo será el hardware que impulsará la próxima ola de inteligencia artificial en la nube.