Foxconn, el gigante taiwanés de la fabricación por contrato que monta de todo, desde smartphones hasta servidores a medida, está moviéndose a una posición muy incómoda para NVIDIA.

Según la prensa de Taiwán, la compañía ha asegurado pedidos relevantes de racks completos construidos alrededor de los TPUs Ironwood de Google, en lugar de limitarse a las clásicas granjas de GPU de NVIDIA. No es un giro dramático de un día para otro, pero sí una señal clara: la cadena de suministro de hardware para IA ya no quiere depender de un único proveedor.

Durante casi toda la explosión de la IA generativa, las GPUs de centro de datos de NVIDIA – A100, H100 y familia – han sido el billete de entrada al juego. El problema: precios disparados, colas de espera eternas y socios que aceptaban cualquier lote que apareciera, simplemente para no quedarse fuera. Más de un integrador bromea con que se cambiaría a “cualquiera menos AMD” con tal de evitar más líos de drivers, pantallas negras y falta de stock. En ese contexto, los TPUs de Google han dejado de ser una curiosidad interna de Google Cloud para convertirse en una plataforma de racks completa que terceros pueden adoptar.

De acuerdo con el diario Economic Daily, Foxconn producirá bandejas de computación para los servidores de IA de Google basados en TPUs, y lo hará siguiendo un esquema muy estricto: por cada rack de TPUs que Google envíe, Foxconn entrega un rack de bandejas de cómputo, manteniendo una proporción 1:1. Al mismo tiempo, la empresa colaborará en los planes de robótica de Google bajo la marca Intrinsic, donde la inteligencia artificial en la nube y la automatización física acaban encontrándose en la misma fábrica.

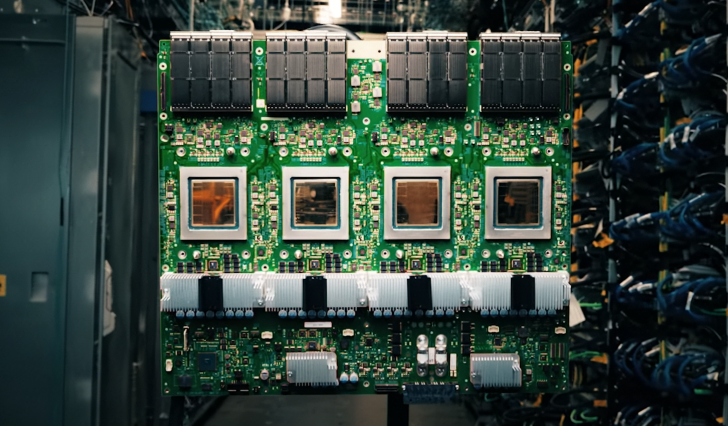

Detrás de este acuerdo no hay hardware menor. Ironwood, la séptima generación de TPUs de Google, se despliega en forma de Superpods: pods preconfigurados que escalan hasta 9.216 chips en un solo clúster. En cargas de trabajo FP8, un Superpod completo se sitúa en torno a los 42,5 exaFLOPS de potencia agregada, unido mediante el InterChip Interconnect de Google. La topología elegida es un diseño en toro 3D, pensado para que cada chip tenga rutas cortas hacia sus vecinos y la latencia se mantenga a raya, de modo que el sistema se comporte más como un único acelerador masivo que como un conjunto suelto de tarjetas.

Lo interesante es cómo encaja todo esto con la economía real de la IA. El entrenamiento de grandes modelos fundacionales sigue siendo espectacular y carísimo, pero ya no es donde se va la mayor parte del dinero. El verdadero coste está en la inferencia: en responder a cada mensaje del chatbot, en cada recomendación de vídeo, en cada consulta al asistente de oficina. Ahí es donde importan la eficiencia energética, la latencia predecible y el coste total de propiedad, no solo el récord de rendimiento en un benchmark. Y es ahí donde los ASIC de propósito específico – TPUs hoy, NPUs y otros diseños mañana – pueden recortar todo lo que sobra del ADN gráfico de una GPU tradicional y dedicar cada milímetro de silicio a multiplicaciones de matrices y ancho de banda.

Google lleva años apostando por controlar todo el stack: diseña sus propios chips, sus placas, su arquitectura de rack, sus compiladores y la capa de software que corre en Google Cloud. NVIDIA, por su parte, ha ido podando componentes típicamente “gamer” de su línea de centros de datos desde la época de A100, pero sigue obligada a servir a un abanico enorme de clientes, desde laboratorios de investigación hasta bancos y proveedores de nube. El resultado es un choque de filosofías: de un lado, un aparato TPU muy cerrado pero extremadamente optimizado de extremo a extremo; del otro, una plataforma GPU mucho más flexible, con una pila de software madurísima, pero también más cara y difícil de escalar cuando todos quieren lo mismo al mismo tiempo.

Todo ello se combina con una cuestión que cada vez quema más: el precio. Muchas empresas admiten en privado que no sienten que cada dólar invertido en servidores con NVIDIA se traduzca directamente en componentes o I+D, sino también en pagar la prima de un mercado en el que prácticamente solo hay un actor dominante. Google, en cambio, tiene un incentivo directo para bajar el coste por consulta dentro de su propio ecosistema: cuanto más barata sea la inferencia, más atractivos y rentables son sus servicios en la nube. Empujar los TPUs hacia fuera, apoyándose en fabricantes como Foxconn para producir Superpods en volumen, encaja perfectamente con esa estrategia.

¿Significa eso que “se acabó” para NVIDIA, como repiten algunos memes? En absoluto. El ecosistema CUDA, la cantidad de bibliotecas optimizadas y la experiencia acumulada en equipos de ciencia de datos y MLOps no desaparecen porque un cliente grande compre un par de pods de TPU. Las GPUs seguirán siendo la opción preferida para investigación, cargas mixtas y escenarios multicloud. Pero el mensaje de fondo sí es claro: los grandes compradores ya no quieren vivir en un mundo con un solo proveedor de aceleradores de alto rendimiento, y el movimiento de Foxconn en torno a Ironwood es una prueba tangible de que la diversificación ya está en marcha.

En ese futuro más fragmentado, Foxconn puede convertirse en una pieza casi tan importante como los logos grabados en los chips. Como ensamblador neutral, es capaz de construir racks para ecosistemas muy distintos – GPU, TPU, NPU y lo que venga después – y ofrecer algo que los gigantes de la nube valoran tanto como los FLOPS: capacidad de producción global y fiabilidad industrial. Los nuevos pedidos vinculados a los Superpods de Google dejan claro que Foxconn quiere estar en primera fila de esta nueva era multivendedor de la infraestructura de IA, justo en el momento en que el histórico dominio de NVIDIA empieza a sentir la presión del silicio a medida diseñado por las propias Big Tech.

1 comentario

si google, meta y compañía se pasan fuerte a tpu, igual algún día volvemos a ver gpu decentes y con stock para gamers… soñar es gratis 🙏