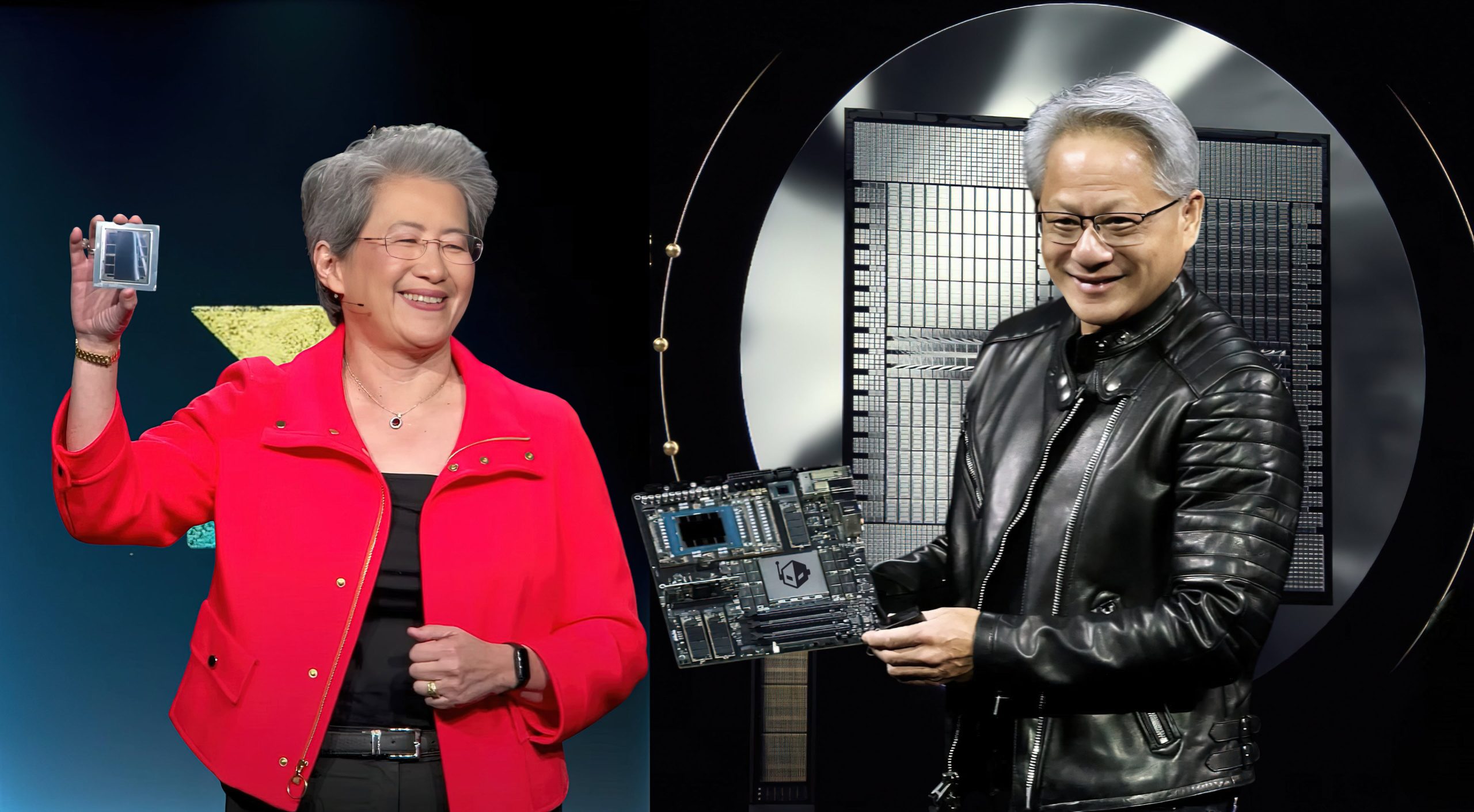

La nueva edición de MLPerf v5.1 AI Inference ya está aquí y ha dejado claro que la batalla por el liderazgo en aceleradores de inteligencia artificial está más intensa que nunca. En el centro del escenario se encuentran la NVIDIA Blackwell Ultra GB300 y la AMD Instinct MI355X, dos chips que representan lo mejor de cada fabricante.

Intel también apareció con su Arc Pro B60, aunque la verdadera competencia se vivió entre NVIDIA y AMD.

NVIDIA Blackwell Ultra GB300 empezó con un golpe contundente. En la prueba DeepSeek R1 (Offline), un clúster de 72 GPUs alcanzó 420.569 muestras por segundo frente a las 289.712 del GB200, lo que supone un 45% más de rendimiento y prácticamente lo prometido por la compañía (50%). Incluso en configuraciones reducidas de 8 GPUs, la GB300 logró 48.047 muestras por segundo, superando en un 44% a su antecesora. En la práctica, significa ciclos de entrenamiento más rápidos, inferencias más fluidas y menor latencia.

En el modo DeepSeek R1 (Server), pensado para cargas dinámicas y consultas en tiempo real, la GB300 también mostró su poder: un 25% más de rendimiento con 72 GPUs y un 21% adicional con 8 GPUs. Para empresas que dependen de asistentes virtuales, chatbots o motores de recomendación, esta mejora puede traducirse en más usuarios atendidos sin necesidad de ampliar infraestructura.

AMD Instinct MI355X llegaba con la intención de demostrar que podía competir de tú a tú, y lo consiguió. En la prueba de Llama 3.1 405B (Offline), una configuración de 8 GPUs logró 2.109 tokens por segundo, un 27% más que el GB200. Una señal clara de que AMD está afinando su arquitectura para desafiar a NVIDIA en escenarios clave.

El momento estelar vino con el benchmark Llama 2 70B (Offline). Con 64 aceleradores, el MI355X generó 648.248 tokens por segundo; con 32 GPUs, 350.820; y con solo 8 GPUs, todavía alcanzó 93.045. El GB200 (8 GPUs) quedó en 65.770. En otras palabras, AMD duplicó la velocidad de NVIDIA en esa prueba, mostrando que su plataforma está especialmente optimizada para grandes modelos de lenguaje generativo.

La Intel Arc Pro B60, aunque con cifras más modestas (3.009 tokens/s en Llama 2 70B), tiene un enfoque distinto. Su punto fuerte es el costo-eficiencia, ideal para equipos pequeños y laboratorios que buscan acelerar cargas de trabajo de IA sin invertir en soluciones de data center.

NVIDIA, por su parte, subrayó que la Blackwell Ultra GB300 no solo es rápida, sino que también bate récords en razonamiento. Frente a la generación Hopper, consiguió un rendimiento 4,7 veces mayor en pruebas offline y 5,2 veces más en servidores. Esto refuerza la idea de que la GB300 está pensada para afrontar tareas lógicas cada vez más complejas, un terreno clave para los sistemas multimodales que combinan visión, lenguaje y razonamiento.

De cara al futuro, lo que viene es aún más competencia. Es probable que NVIDIA, AMD e Intel sigan puliendo sus ecosistemas de software y drivers, lo que traerá puntuaciones aún más altas en próximos MLPerf. Para los usuarios, la decisión ya no dependerá solo de las cifras de rendimiento, sino también de la compatibilidad con cargas específicas, del ecosistema y del costo total de operación. Lo único seguro es que la vara en inferencia de IA acaba de subir a otro nivel.

2 comentarios

ya quiero ver el mlperf v6.0

amd por fin dando guerra de verdad