NVIDIA sigue liderando la IA, pero los chips personalizados están revolucionando el juego

Durante casi una década, NVIDIA ha sido el corazón de la inteligencia artificial moderna. Sus GPUs impulsan desde los modelos de lenguaje más avanzados hasta los sistemas de conducción autónoma. Pero en 2025, la situación empieza a cambiar: los costos energéticos, la escasez de hardware y la necesidad de eficiencia están abriendo paso a una nueva generación de chips personalizados, los ASIC (Application-Specific Integrated Circuits), diseñados específicamente para tareas de IA.

Para comprender esta transformación, hablamos con Rahul Sen Sharma, presidente y codirector ejecutivo de Indxx, una firma internacional que analiza el sector tecnológico y los mercados emergentes. Sharma explicó por qué NVIDIA sigue siendo el pilar de la IA, pero también cómo los chips personalizados podrían alterar el equilibrio de poder en los próximos años.

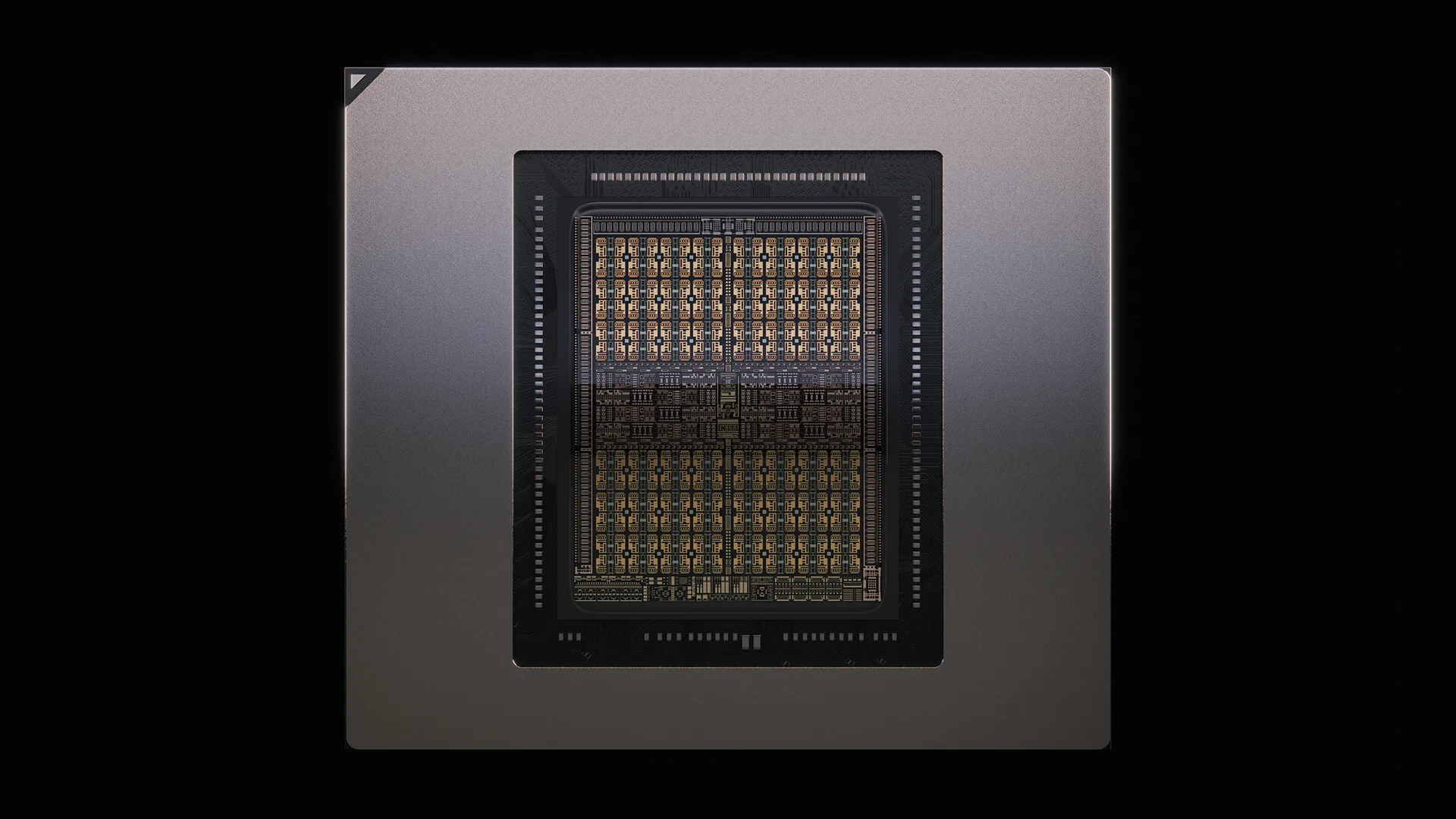

CUDA y Blackwell: la base del imperio de NVIDIA

NVIDIA domina actualmente el 86% del mercado mundial de GPUs dedicadas a IA. Su fuerza no está solo en el hardware, sino en su ecosistema de software: CUDA, una plataforma que se ha convertido en el estándar de facto para el desarrollo de inteligencia artificial. Gracias a CUDA, millones de desarrolladores diseñan, entrenan y ejecutan modelos optimizados para las GPUs de NVIDIA, reforzando un círculo de dependencia difícil de romper.

Las GPUs de la serie Blackwell son el motor de la mayoría de las infraestructuras de IA actuales, desde el entrenamiento de modelos de lenguaje hasta la inferencia en aplicaciones de consumo. “NVIDIA no vende solo chips, vende una plataforma completa”, señaló Sharma. “Esa combinación de rendimiento y ecosistema maduro le ha dado una ventaja casi inalcanzable”.

Pero el monopolio se resquebraja

El panorama tecnológico empieza a diversificarse. Los gigantes del sector – Google, Amazon, Meta, Microsoft y OpenAI – están apostando por sus propios chips diseñados para tareas concretas, con el objetivo de ganar eficiencia y reducir costos. OpenAI, por ejemplo, colabora con Broadcom en el desarrollo de ASICs fabricados con el proceso de 3 nanómetros de TSMC. Estos chips, pensados para la inferencia, se usarán únicamente en los centros de datos de la compañía.

Este movimiento sigue el ejemplo de otras grandes tecnológicas: Google con sus TPUs, Amazon con Trainium e Inferentia, Microsoft con Athena y Meta con MTIA. Todas buscan depender menos de NVIDIA, cuyos chips son caros y difíciles de conseguir en grandes volúmenes. Así, se consolida un modelo híbrido: GPUs para el entrenamiento y ASICs para la inferencia.

Broadcom: el rival silencioso que gana terreno

Broadcom se ha convertido en uno de los competidores más serios de NVIDIA. Tradicionalmente asociada a chips de red, la empresa ha diversificado su negocio y ha logrado un crecimiento impresionante en el sector de IA. En el segundo trimestre de 2025, sus ingresos por soluciones de inteligencia artificial alcanzaron los 4.400 millones de dólares, un aumento del 46% interanual. La clave: alianzas con gigantes de la nube y una estrategia centrada en chips personalizados.

“Broadcom está posicionándose de forma muy inteligente”, dijo Sharma. “No compite con NVIDIA directamente en todo, pero está ocupando nichos donde la eficiencia energética y el costo importan más que la potencia bruta.” Gracias a su adquisición de VMware y acuerdos con los principales proveedores de la nube, la compañía está consolidando una posición que podría hacerla indispensable para el futuro de la IA.

De la potencia absoluta al rendimiento por costo

La expansión de la inteligencia artificial no es barata. Los centros de datos consumen cantidades colosales de energía y agua, y las empresas tecnológicas sienten la presión de mantener un equilibrio entre rendimiento y rentabilidad. “Los hyperscalers están dejando de perseguir el rendimiento máximo; ahora buscan la mejor relación rendimiento/costo”, explicó Sharma.

Amazon lidera esta tendencia con sus chips Trainium: aunque no igualan a los de NVIDIA en rendimiento máximo, ofrecen menor costo operativo y mayor eficiencia energética. Google, Microsoft y Meta han seguido la misma estrategia, desarrollando chips propios adaptados a sus ecosistemas. Hoy, las grandes empresas tecnológicas combinan GPUs de NVIDIA para las tareas más exigentes con sus chips internos para optimizar costes y autonomía.

El futuro de los ASICs: eficiencia e inteligencia

Sharma destaca que los ASICs aún tienen mucho margen de mejora. Las innovaciones que vienen apuntan a una nueva era de eficiencia, seguridad y personalización:

- Eficiencia energética: Al ser diseñados para tareas específicas, evitan el consumo innecesario de recursos y pueden ahorrar hasta un 30% de energía frente a CPUs o GPUs.

- Seguridad: Los nuevos ASICs incorporarán cifrado nativo y resistencia física frente a ataques, una necesidad ante el aumento de ciberamenazas.

- Especialización: Los chips dedicados a tareas concretas – como procesamiento de video o inferencia lingüística – logran un rendimiento mucho mayor por vatio.

- Integración con IA: Estos chips trabajarán de forma más estrecha con TPUs y otros aceleradores, impulsando análisis en tiempo real y aplicaciones autónomas.

- Desagregación de memoria: Gracias a tecnologías como Compute Express Link (CXL), los ASICs podrán acceder a memoria compartida, mejorando la eficiencia de los modelos de gran escala.

En conjunto, los ASICs se perfilan como los protagonistas de la próxima fase de la revolución de la inteligencia artificial.

Quién gana con el auge de los chips personalizados

El crecimiento del mercado de ASIC beneficia a todo un ecosistema de empresas. Desde los hyperscalers que ganan independencia hasta los fabricantes de semiconductores que multiplican su producción, todos encuentran nuevas oportunidades.

- Hyperscalers: Amazon, Google, Microsoft y Meta reducen costos y dependencia con chips diseñados internamente.

- Fabricantes: TSMC y Samsung lideran la producción, mientras Broadcom, AMD e Intel apuestan por diseños semi-customizados.

- Software de diseño: Synopsys, Cadence y Siemens EDA proporcionan las herramientas clave para el desarrollo de ASICs.

- Memoria y conectividad: Micron, SK Hynix y Rambus avanzan en la compatibilidad con la tecnología CXL.

- Infraestructura y enfriamiento: Vertiv, Schneider Electric y CoolIT Systems lideran la adaptación térmica de los centros de datos.

El hardware de la IA se convierte así en una carrera por la eficiencia, donde la ingeniería térmica y la sostenibilidad son tan cruciales como la potencia de cálculo.

Rubin GPUs: potencia extrema, calor extremo

Durante la GTC 2025, NVIDIA presentó las GPUs Rubin y Rubin Ultra, las más potentes de su historia. Pero con la potencia llegó también el desafío del calor: la densidad energética por rack es tan alta que el enfriamiento por aire ya no basta. “Rubin cambia las reglas del diseño de centros de datos”, señaló Sharma. “Sin refrigeración líquida, estos sistemas no son viables.”

CoolIT Systems, Asetek y otras compañías ya están innovando en soluciones de enfriamiento líquido para grandes instalaciones. CoolIT presentó sus nuevos sistemas con tecnología Split-Flow, que ofrecen hasta un 30% más de eficiencia térmica. Vertiv y Schneider Electric también modernizan infraestructuras para soportar esta nueva generación de chips.

El enfriamiento, antes un tema técnico secundario, se ha convertido en un factor estratégico. En la era de Rubin, incluso la temperatura define quién lidera la carrera de la inteligencia artificial.

Un nuevo equilibrio

NVIDIA sigue siendo el gigante indiscutible del hardware de IA, pero el futuro será más diverso. Los chips personalizados anuncian una nueva era de competencia y eficiencia. Ya no se trata solo de quién tiene más potencia, sino de quién la usa mejor.

Como concluyó Sharma: “NVIDIA no desaparecerá, pero tendrá que compartir el escenario”.