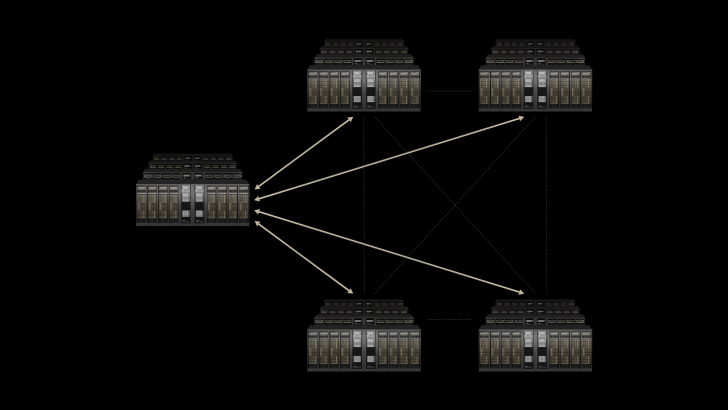

NVIDIA quiere redefinir la infraestructura de IA con Spectrum-XGS, una tecnología pensada para unir varios centros de datos en un único “giga-clúster”.

En lugar de seguir inflando un solo centro – donde el consumo eléctrico, la refrigeración y las limitaciones físicas se convierten en problemas enormes – la propuesta es conectar instalaciones completas en una red computacional global.

El CEO Jensen Huang describe Spectrum-XGS como una evolución de la plataforma Ethernet Spectrum. A la clásica escalabilidad vertical y horizontal ahora se suma la idea de “escalar a través”, lo que permite enlazar centros de datos en distintas ciudades, países e incluso continentes. El resultado: fábricas de IA a una escala nunca vista.

La clave está en el rendimiento. Según NVIDIA, Spectrum-XGS duplica la eficiencia frente a NCCL, su anterior solución de interconexión de GPUs. Entre sus novedades se incluyen el control automático de congestión a larga distancia y la gestión de la latencia, para que los enlaces entre centros alejados no se conviertan en un cuello de botella.

El primer gigante en adoptar esta tecnología será Coreweave. Para NVIDIA, este paso acelerará la innovación en todo tipo de industrias, demostrando que el futuro de la IA no se construye solo “más alto”, sino uniendo recursos de forma inteligente y distribuida.

El lanzamiento se suma a iniciativas previas como los switches de red basados en fotónica de silicio y refleja la ambición de NVIDIA de liderar no solo en GPUs, sino en todo el tejido que conecta la infraestructura de IA. Con Spectrum-XGS, la apuesta ya no es un megaedificio lleno de servidores, sino una red global de centros de datos interconectados capaz de redefinir qué significa “escala” en el mundo de la inteligencia artificial.

1 comentario

jajaja esto es como la escena de 1.21 gigawatts ⚡️